Markov-prosesser ble utviklet av forskere i 1907. Ledende matematikere på den tiden utviklet denne teorien, noen av dem forbedrer den fortsatt. Dette systemet strekker seg også til andre vitenskapelige felt. Praktiske Markov-kjeder brukes i ulike områder der en person trenger å ankomme i en forventningstilstand. Men for å forstå systemet tydelig, må du ha kunnskap om vilkårene og bestemmelsene. Tilfeldighet anses å være hovedfaktoren som bestemmer Markov-prosessen. Riktignok ligner det ikke på begrepet usikkerhet. Den har visse betingelser og variabler.

Funksjoner ved tilfeldighetsfaktoren

Denne tilstanden er underlagt statisk stabilitet, nærmere bestemt regelmessighetene, som ikke tas i betraktning i tilfelle usikkerhet. I sin tur tillater dette kriteriet bruk av matematiske metoder i teorien om Markov-prosesser, som bemerket av en forsker som studerte dynamikken til sannsynligheter. Arbeidet han skapte handlet direkte med disse variablene. I sin tur, den studerte og utviklede tilfeldige prosessen, som har begrepene stat ogovergang, samt brukt i stokastiske og matematiske problemer, samtidig som de lar disse modellene fungere. Det gir blant annet en mulighet til å forbedre andre viktige anvendte teoretiske og praktiske vitenskaper:

- diffusjonsteori;

- køteori;

- teori om pålitelighet og andre ting;

- kjemi;

- fysikk;

- mekanikk.

Vessentlige trekk ved en ikke-planlagt faktor

Denne Markov-prosessen er drevet av en tilfeldig funksjon, det vil si at enhver verdi av argumentet betraktes som en gitt verdi eller en som har en forhåndsforberedt form. Eksempler er:

- svingninger i kretsen;

- flyttehastighet;

- overflateruhet i et gitt område.

Det er også en vanlig oppfatning at tid er et faktum av en tilfeldig funksjon, det vil si at indeksering forekommer. En klassifisering har form av en tilstand og et argument. Denne prosessen kan være med diskrete så vel som kontinuerlige tilstander eller tid. Dessuten er tilfellene forskjellige: alt skjer enten i en eller annen form, eller samtidig.

Detaljert analyse av begrepet tilfeldighet

Det var ganske vanskelig å bygge en matematisk modell med de nødvendige ytelsesindikatorene i en tydelig analytisk form. I fremtiden ble det mulig å realisere denne oppgaven, fordi en tilfeldig Markov-prosess oppsto. Ved å analysere dette konseptet i detalj, er det nødvendig å utlede et visst teorem. En Markov-prosess er et fysisk system som har endret sittposisjon og tilstand som ikke er forhåndsprogrammert. Dermed viser det seg at det foregår en tilfeldig prosess i den. For eksempel: en rombane og et skip som skytes inn i den. Resultatet ble oppnådd bare på grunn av noen unøyaktigheter og justeringer, uten hvilke den angitte modusen ikke er implementert. De fleste av de pågående prosessene er iboende i tilfeldighet, usikkerhet.

For meritter, nesten alle alternativer som kan vurderes vil være underlagt denne faktoren. Et fly, en teknisk enhet, en spisestue, en klokke - alt dette er gjenstand for tilfeldige endringer. Dessuten er denne funksjonen iboende i enhver pågående prosess i den virkelige verden. Men så lenge dette ikke gjelder individuelt innstilte parametere, oppfattes forstyrrelsene som oppstår som deterministiske.

Konseptet med en Markov stokastisk prosess

Enhet som designer en hvilken som helst teknisk eller mekanisk enhet, tvinger skaperen til å ta hensyn til ulike faktorer, spesielt usikkerhet. Beregningen av tilfeldige svingninger og forstyrrelser oppstår i øyeblikket av personlig interesse, for eksempel ved implementering av en autopilot. Noen av prosessene som studeres i vitenskaper som fysikk og mekanikk er.

Men å ta hensyn til dem og utføre grundig forskning bør begynne i det øyeblikket det er direkte nødvendig. En tilfeldig Markov-prosess har følgende definisjon: sannsynlighetskarakteristikken til den fremtidige formen avhenger av tilstanden den er i på et gitt tidspunkt, og har ingenting å gjøre med hvordan systemet så ut. Så gittkonseptet indikerer at utfallet kan forutsies, kun vurderer sannsynligheten og glemmer bakgrunnen.

Detaljert forklaring av konseptet

For øyeblikket er systemet i en viss tilstand, det beveger seg og endrer seg, det er i utgangspunktet umulig å forutsi hva som vil skje videre. Men gitt sannsynligheten kan vi si at prosessen vil bli fullført i en viss form eller beholde den forrige. Det vil si at fremtiden oppstår fra nåtiden, og glemmer fortiden. Når et system eller en prosess går inn i en ny tilstand, blir historikken vanligvis utelatt. Sannsynlighet spiller en viktig rolle i Markov-prosesser.

Geigertelleren viser for eksempel antall partikler, som avhenger av en bestemt indikator, og ikke av det eksakte øyeblikket den kom. Her er hovedkriteriet ovenfor. I praktisk anvendelse kan ikke bare Markov-prosesser vurderes, men også lignende, for eksempel: fly deltar i slaget om systemet, som hver er indikert med en eller annen farge. I dette tilfellet er hovedkriteriet igjen sannsynligheten. På hvilket tidspunkt overvekten i antall vil oppstå, og for hvilken farge, er ukjent. Det vil si at denne faktoren avhenger av tilstanden til systemet, og ikke av sekvensen av flydødsfall.

Strukturanalyse av prosesser

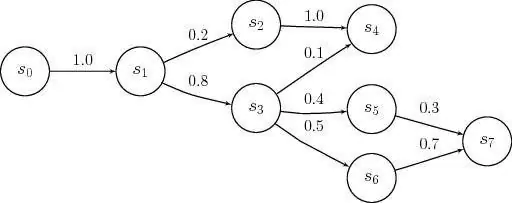

En Markov-prosess er en hvilken som helst tilstand i et system uten en sannsynlig konsekvens og uten hensyn til historien. Det vil si hvis du inkluderer fremtiden i nåtiden og utelater fortiden. Overmetning av denne tiden med forhistorie vil føre til flerdimensjonalitet ogvil vise komplekse konstruksjoner av kretsløp. Derfor er det bedre å studere disse systemene med enkle kretsløp med minimale numeriske parametere. Som et resultat blir disse variablene ansett som bestemmende og betinget av noen faktorer.

Et eksempel på Markov-prosesser: en fungerende teknisk enhet som er i god stand for øyeblikket. I denne tilstanden er det som er av interesse sannsynligheten for at enheten vil fungere over en lengre periode. Men hvis vi oppfatter utstyret som feilsøkt, vil dette alternativet ikke lenger tilhøre prosessen under vurdering på grunn av det faktum at det ikke er informasjon om hvor lenge enheten fungerte før og om reparasjoner ble utført. Men hvis disse to tidsvariablene suppleres og inkluderes i systemet, kan tilstanden tilskrives Markov.

Beskrivelse av diskret tilstand og kontinuitet i tiden

Markov prosessmodeller brukes i det øyeblikket det er nødvendig å neglisjere forhistorien. For forskning i praksis møter man oftest diskrete, kontinuerlige tilstander. Eksempler på en slik situasjon er: utstyrets struktur inkluderer noder som kan svikte i arbeidstiden, og dette skjer som en ikke-planlagt, tilfeldig handling. Som et resultat blir systemets tilstand reparert av det ene eller det andre elementet, i dette øyeblikket vil en av dem være frisk eller begge vil bli feilsøkt, eller omvendt, de er fullstendig justert.

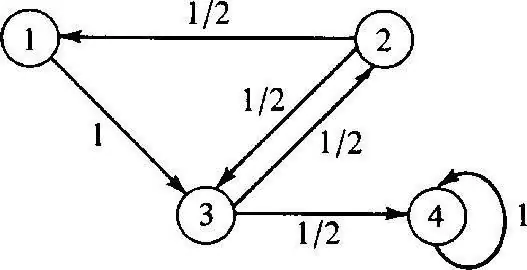

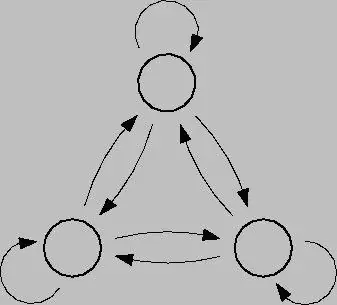

Den diskrete Markov-prosessen er basert på sannsynlighetsteori og er også detovergang av systemet fra en tilstand til en annen. Dessuten oppstår denne faktoren umiddelbart, selv om utilsiktede sammenbrudd og reparasjonsarbeid oppstår. For å analysere en slik prosess er det bedre å bruke tilstandsgrafer, det vil si geometriske diagrammer. Systemtilstander i dette tilfellet er indikert med forskjellige former: trekanter, rektangler, prikker, piler.

Modellering av denne prosessen

Diskret-state Markov-prosesser er mulige modifikasjoner av systemer som følge av en øyeblikkelig overgang, og som kan nummereres. For eksempel kan du bygge en tilstandsgraf fra piler for noder, der hver vil indikere banen til forskjellig rettede feilfaktorer, driftstilstand osv. I fremtiden kan det oppstå spørsmål: for eksempel det faktum at ikke alle geometriske elementer peker i riktig retning, fordi i prosessen kan hver node forringes. Når du jobber er det viktig å vurdere nedleggelser.

Kontinuerlig Markov-prosess skjer når dataene ikke er forhåndsfiksert, det skjer tilfeldig. Overganger var ikke tidligere planlagt og skjer i hopp, når som helst. I dette tilfellet, igjen, spilles hovedrollen av sannsynlighet. Men hvis den nåværende situasjonen er en av de ovennevnte, vil det kreves en matematisk modell for å beskrive den, men det er viktig å forstå teorien om mulighet.

Probabilistiske teorier

Disse teoriene vurderer sannsynlighet, med karakteristiske trekk somtilfeldig rekkefølge, bevegelse og faktorer, matematiske problemer, ikke deterministiske, som er sikre nå og da. En kontrollert Markov-prosess har og er basert på en mulighetsfaktor. Dessuten er dette systemet i stand til å bytte til hvilken som helst tilstand umiddelbart under forskjellige forhold og tidsintervaller.

For å sette denne teorien ut i livet, er det nødvendig å ha en viktig kunnskap om sannsynlighet og dens anvendelse. I de fleste tilfeller er man i en forventningstilstand, som i generell forstand er teorien det er snakk om.

Eksempler på sannsynlighetsteori

Eksempler på Markov-prosesser i denne situasjonen kan være:

- kafé;

- billettkontorer;

- verksteder;

- stasjoner for ulike formål osv.

Som regel håndterer folk dette systemet hver dag, i dag kalles det kø. Ved anlegg hvor en slik tjeneste finnes, er det mulig å kreve ulike forespørsler, som tilfredsstilles i prosessen.

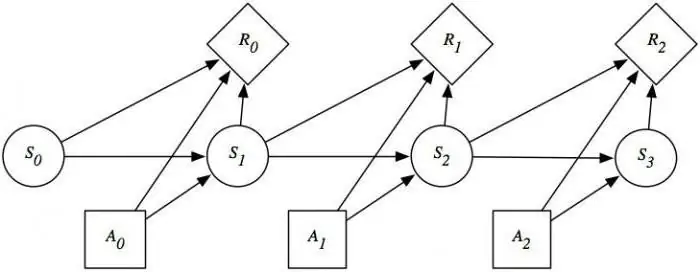

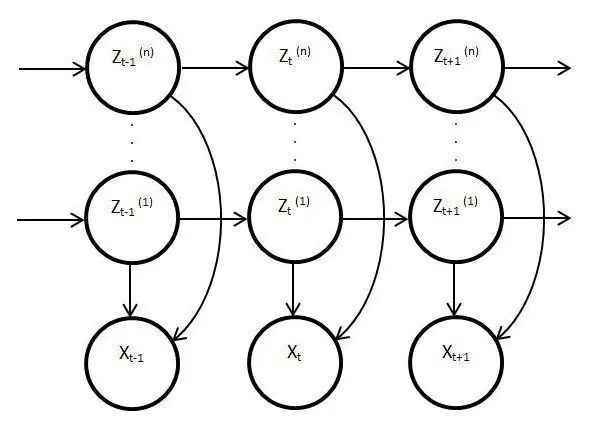

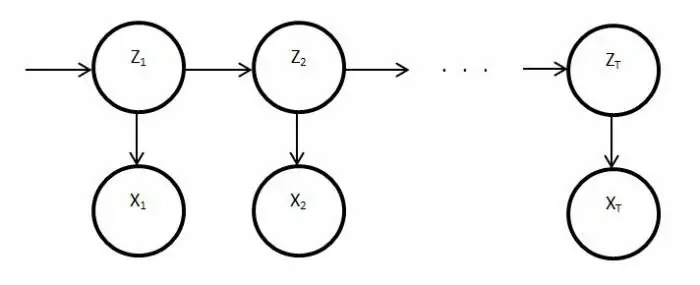

Skjulte prosessmodeller

Slike modeller er statiske og kopierer arbeidet med den originale prosessen. I dette tilfellet er hovedfunksjonen funksjonen til å overvåke ukjente parametere som må nøstes opp. Som et resultat kan disse elementene brukes i analyse, praksis eller til å gjenkjenne ulike objekter. Vanlige Markov-prosesser er basert på synlige overganger og på sannsynlighet, kun ukjente observeres i den latente modellenvariabler påvirket av staten.

Vesentlig avsløring av skjulte Markov-modeller

Den har også en sannsynlighetsfordeling blant andre verdier, som et resultat vil forskeren se en sekvens av tegn og tilstander. Hver handling har en sannsynlighetsfordeling blant andre verdier, så den latente modellen gir informasjon om de genererte suksessive tilstandene. De første notatene og referansene til dem dukket opp på slutten av sekstitallet av forrige århundre.

Så ble de brukt til talegjenkjenning og som analyser av biologiske data. I tillegg har latente modeller spredt seg i skrift, bevegelser, informatikk. Disse elementene imiterer også arbeidet med hovedprosessen og forblir statiske, men til tross for dette er det mye mer karakteristiske trekk. Spesielt gjelder dette faktum direkte observasjon og sekvensgenerering.

Stasjonær Markov-prosess

Denne betingelsen eksisterer for en homogen overgangsfunksjon, så vel som for en stasjonær fordeling, som anses som hovedhandlingen og per definisjon en tilfeldig handling. Faserommet for denne prosessen er et begrenset sett, men i denne tilstanden eksisterer alltid den innledende differensieringen. Overgangssannsynligheter i denne prosessen vurderes under tidsforhold eller tilleggselementer.

Detaljert studie av Markov-modeller og prosesser avslører spørsmålet om å tilfredsstille balansen på ulike områder av livetog samfunnets aktiviteter. Gitt at denne industrien påvirker vitenskap og massetjenester, kan situasjonen korrigeres ved å analysere og forutsi utfallet av eventuelle hendelser eller handlinger av de samme defekte klokkene eller utstyret. For å fullt ut bruke egenskapene til Markov-prosessen, er det verdt å forstå dem i detalj. Tross alt har denne enheten funnet bred anvendelse ikke bare innen vitenskap, men også i spill. Dette systemet i sin rene form vurderes vanligvis ikke, og hvis det brukes, da kun på grunnlag av de ovennevnte modellene og ordningene.